Proyecto TANGO: Investigadoras de la Facultad participan en estudio sobre la evolución de lacordillera de los Andes

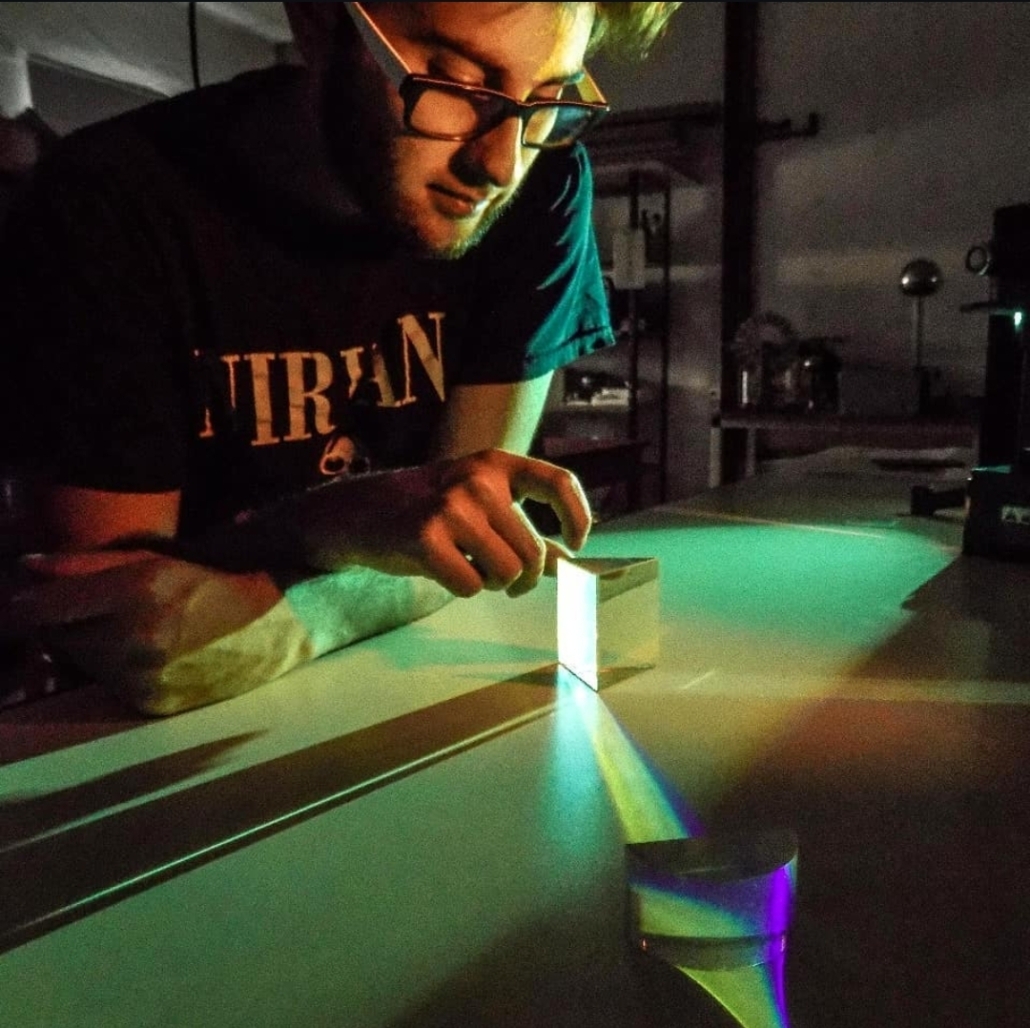

La becaria doctoral, Marina Escobares y la investigadora, Silvana Spagnotto, ambas del Departamento de Física de la FCFMyN, participaron de un viaje científico a Estados Unidos el pasado 22 de abril. Su destino inicial fue la Universidad de Arizona en Tucson, seguido por una estancia de Escobares en el Instituto Politécnico Rensselaer en Troy, Nueva York.

El proyecto TANGO (TransAndean Great Orogeny Project) es una ambiciosa iniciativa científica que tiene como objetivo entender la evolución de la Cordillera de los Andes. Intenta responder a preguntas sobre cómo y por qué los Andes se formaron, cómo han evolucionado a lo largo del tiempo, y cómo esta evolución está relacionada con los procesos tectónicos. Para ello, han desplegado una red de estaciones sismológicas en Chile y Argentina, buscando analizar el engrosamiento y acortamiento cortical mediante enfoques geológicos y sísmicos.

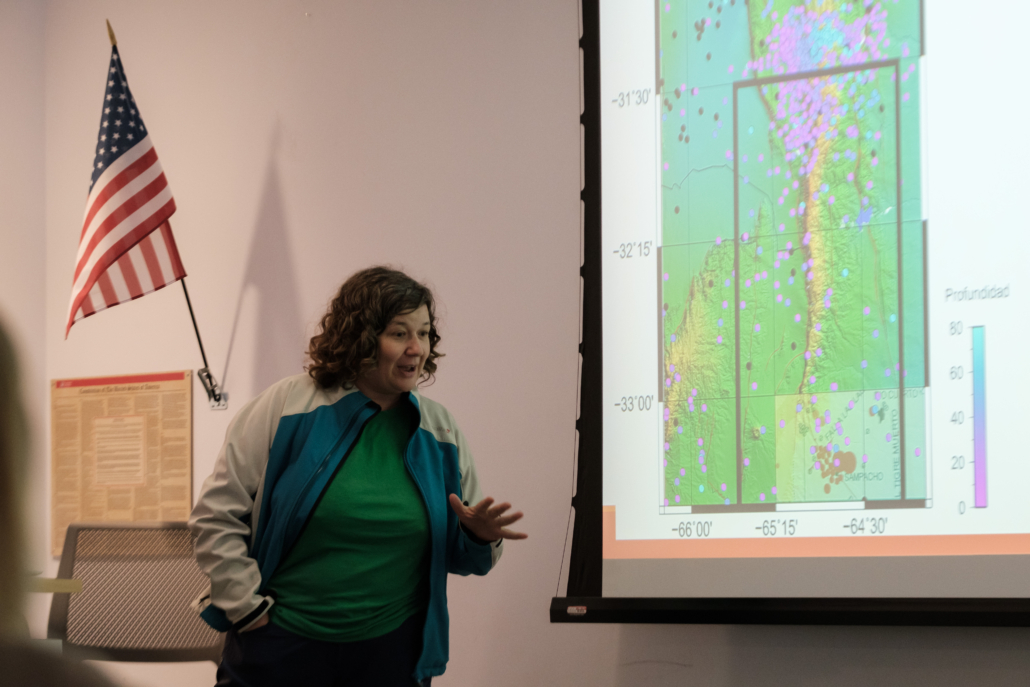

Durante su estancia en Arizona, las investigadoras participaron en un workshop intensivo organizado por los doctores Susan Beck y Steven Roecker, donde se llevaron a cabo discusiones grupales y se compartieron avances del Proyecto. Además, realizaron salidas de campo para observar de primera mano las formaciones geológicas relevantes. Posteriormente, Marina Escobares se trasladó a Troy, Nueva York, para colaborar con el Dr. Steven Roecker en tareas específicas de procesamiento de datos sísmicos.

Esta movilidad fue posible gracias al financiamiento de la Fundación Nacional de Ciencias (NSF) de Estados Unidos, a través de subvenciones del Instituto Politécnico Rensselaer y del Proyecto Internacional TANGO.

En diálogo con la Facultad, Marina Escobares compartió detalles sobre la experiencia que surgió a raíz del vínculo que pudieron establecer con el Dr. Roecker en Chile, en el que le anticiparon la intención de utilizar el programa desarrollado para la realización de una tomografía sísmica en las Sierras de San Luis, como parte de su investigación doctoral. Ese primer encuentro posibilitó una visita posterior a la UNSL en la que se fortalecieron los vínculos que derivaron en la invitación para viajar a EEUU y mostrar los avances locales.

“Fue una muy buena experiencia y una gran oportunidad para mi desarrollo profesional. Conocer científicos de renombre, poder aprender de ellos y su forma de abordar los problemas fue una experiencia valiosa y enriquecedora”, cuenta Marina.

Un concepto clave del proyecto es el “engrosamiento y acortamiento cortical”. ¿Qué significa esto y por qué es crucial para entender la evolución de los Andes?

“Nos referimos a los procesos tectónicos involucrados cuando las placas de la corteza terrestre interactúan entre sí. La corteza terrestre de los Andes se deforma y cambia a medida que las placas tectónicas se empujan, chocan y se deslizan unas sobre otras. El proceso de levantamiento de montañas implica que la corteza se engrose, para que pueda mantenerse erguida, por un proceso conocido como Isostasia”.

Sobre las estaciones instaladas en Chile y Argentina para la recopilación de datos geofísicos, explica “En mi caso, los datos sísmicos son fundamentales para mi investigación. Las estaciones se ubican estratégicamente en puntos clave de la cordillera y del frente, y cada una de ellas está equipada con sensores avanzados para monitorear diferentes fenómenos geológicos”.

Durante la estadía, realizaron salidas al campo. ¿Qué tipo de observaciones o trabajos realizaron y qué importancia tienen para el proyecto?

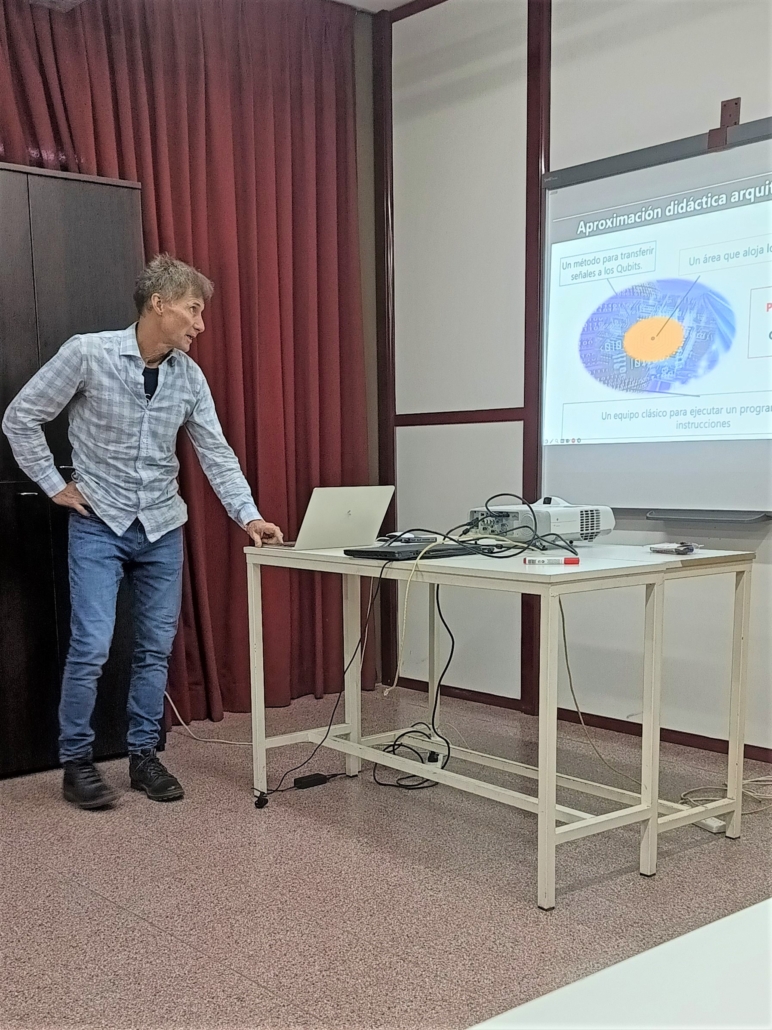

Durante el viaje de campo bordeamos “The Santa Catalina Mountains”, los profesores Paul Kapp and Peter DeCelles nos contaron sobre la historia geológica de la sierra y visitamos algunas zonas de interés. Fue una salida al campo tranquila, muchos de nosotros al ser de otros países, no conocíamos la historia geológica de esa área. Nos dieron una especie de introducción o una charla muy general en cada una de las paradas que hicimos. Reconocimos estructuras asociadas a la extensión que comenzó hace unos 17 millones de años, a principios del Mioceno, y dio lugar a las famosas ¨Basin and Ranges¨. Esta extensión se debe a que la placa Farallon fue subducida completamente y quedó una ventana astenosferica que permitió el ascenso caliente del manto.

Posteriormente, viajaste a Troy, Nueva York, para realizar tareas de procesamiento ¿En qué consistió específicamente este procesamiento de datos? ¿Qué tipo de datos estabas analizando y qué resultados preliminares o desafíos encontraste?

“El profesor Steven Roecker me ayudó con el procesamiento de datos sísmicos, lo que implica varias etapas técnicas que permiten convertir las señales crudas (registradas por las estaciones sísmicas) en información útil para los científicos. Uno de los desafíos encontrados fue la presencia de ruido en mis datos, lo que hace difícil la detección de eventos sísmicos reales. Esto además si no es corregido desde un principio puede generar más problemas a medida que se avanza con el procesado”.

Como becaria del Departamento de Física, ¿cuál es tu rol específico dentro del proyecto TANGO y cómo se alinearon las tareas que realizaste durante el viaje con tus investigaciones o tu plan de beca?

“Mi participación implica el procesado de algunas estaciones de la red de TANGO para tomografías locales, de las Sierras Pampeanas. Estas tareas son parte de mi plan de doctorado y de beca de CONICET, además”.

¿De qué manera esta experiencia internacional y las actividades han enriquecido tu formación y tu perspectiva como investigadora?

“Me vine con muchas ganas de seguir trabajando, procesando, etc. Lo que veía tan lejano, ahora ya no lo está. Me vine pensando que todo es posible, hay que ponerle más esfuerzo y dedicación. Es la única forma de conseguir lo que uno quiere”.

Finalmente, Marina destacó la importancia del apoyo financiero internacional como el de la NSF: “Este tipo de financiamiento promueve la logística y el desarrollo de infraestructura, pero además promueve la colaboración internacional y permite que las investigaciones tengan un impacto más amplio en la comunidad científica global”.